فهرست محتوا

مقدمه:

LocalAI یکی از ترندهای جدید در دنیای هوش مصنوعی است که به شما امکان میدهد قابلیتهای شبیه به ChatGPT و APIهای OpenAI را مستقیماً روی سرور شخصی یا سرور مجازی خود اجرا کنید. اگر تا امروز برای استفاده از هوش مصنوعی مجبور بودید دادههایتان را به سرورهای خارجی بفرستید یا هزینههای بالای اشتراک OpenAI را پرداخت کنید، حالا با این ابزار میتوانید همه چیز را بهصورت محلی و تحت کنترل خودتان داشته باشید.

با اجرای آن روی VPS، نه تنها از هزینههای اضافی خلاص میشوید، بلکه حریم خصوصی دادههایتان هم تضمین میشود. این ابزار اوپنسورس با پشتیبانی از مدلهای مختلف مانند LLaMA، Mistral و Falcon، گزینهای ایدهآل برای توسعهدهندگان، استارتاپها و حتی کاربرانی است که میخواهند تجربهای مشابه ChatGPT را روی زیرساخت شخصیشان داشته باشند.

LocalAI چیست؟

LocalAI یک پروژه اوپنسورس است که امکان اجرای مدلهای هوش مصنوعی مشابه ChatGPT را روی سرور شخصی یا سرور مجازی فراهم میکند. مهمترین ویژگی LocalAI این است که رابط و ساختار API آن کاملاً با OpenAI سازگار است. به این معنا که هر برنامه یا اسکریپتی که برای استفاده از APIهای OpenAI طراحی شده، بدون تغییر خاصی میتواند به LocalAI متصل شود.

تفاوت اصلی LocalAI با OpenAI در محل اجرای مدلهاست. در حالی که OpenAI سرویسهای خود را بر بستر سرورهای ابری ارائه میدهد و دادههای کاربران روی زیرساخت آنها پردازش میشود، LocalAI به شما این امکان را میدهد که همه چیز را بهطور محلی روی سرور خودتان اجرا کنید. این موضوع باعث میشود کنترل کامل بر دادهها و زیرساخت داشته باشید و دیگر نیازی به ارسال اطلاعات حساس به سرورهای خارجی نباشد.

مزایای اصلی استفاده از LocalAI شامل حفظ حریم خصوصی، کاهش هزینههای مربوط به استفاده از APIهای تجاری و امکان کنترل کامل بر مدلها و تنظیمات است. به همین دلیل این ابزار بهویژه برای توسعهدهندگان، شرکتهای فناور و کسبوکارهایی که به امنیت دادهها اهمیت میدهند، گزینهای بسیار ارزشمند محسوب میشود.

ویژگیها و قابلیتهای LocalAI

LocalAI بهعنوان یکی از راهکارهای نوین در حوزه هوش مصنوعی، مجموعهای از ویژگیها و قابلیتها را ارائه میدهد که آن را برای توسعهدهندگان و کسبوکارها بسیار جذاب کرده است:

۱. سازگاری کامل با ساختار API OpenAI

یکی از مهمترین نقاط قوت

۲. پشتیبانی از مدلهای متنوع

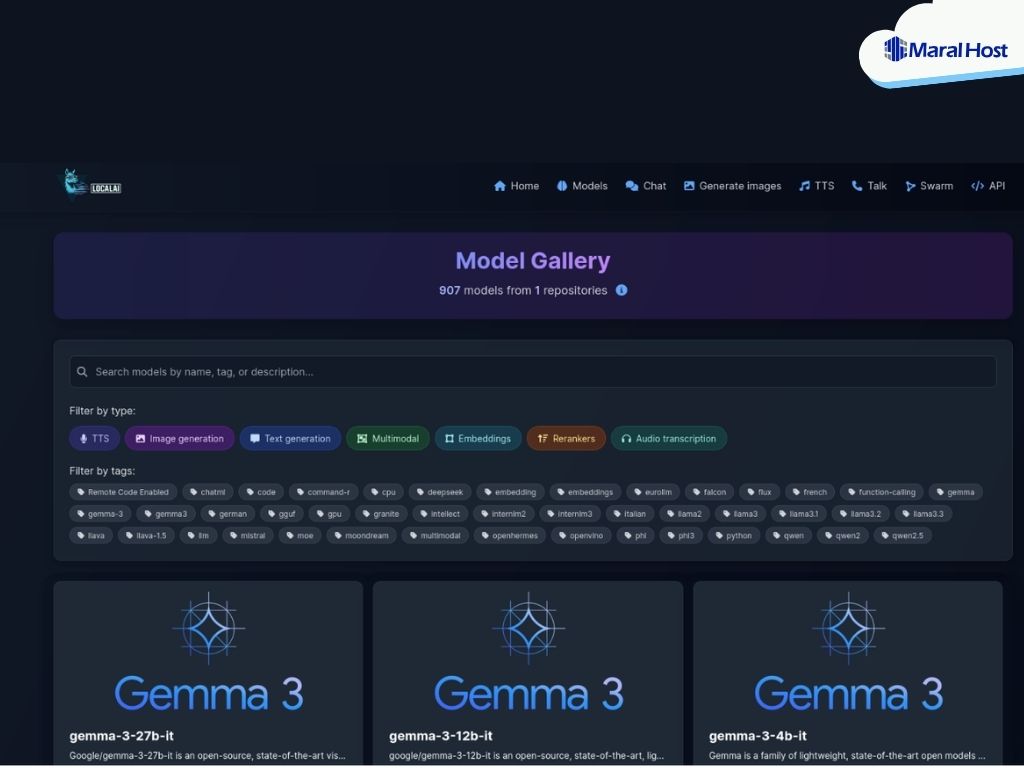

LocalAI محدود به یک مدل خاص نیست، بلکه امکان اجرای طیف گستردهای از مدلهای هوش مصنوعی را فراهم میکند. از جمله:

-

LLaMA (متعلق به Meta) برای پردازش زبان طبیعی

-

Mistral (مدل سبک و قدرتمند اروپایی)

-

Falcon (بهینه برای عملکرد سریع در مقیاس بزرگ)

-

Whisper برای تبدیل صدا به متن (Speech-to-Text)

-

مدلهای Embedding برای جستجو، دستهبندی و تحلیل متون

این تنوع باعث میشود LocalAI تقریباً تمام نیازهای مرتبط با پردازش متن، گفتار و دادههای هوش مصنوعی را پوشش دهد.

۳. اجرای لوکال با CPU یا GPU

LocalAI انعطافپذیری بالایی در اجرا دارد. شما میتوانید آن را روی یک سرور ساده با CPU راهاندازی کنید یا برای سرعت و کارایی بیشتر از GPU استفاده کنید. این قابلیت به کاربران اجازه میدهد بسته به منابع سختافزاری و بودجه خود، بهترین گزینه را انتخاب کنند. بهویژه برای مدلهای بزرگتر، استفاده از GPU باعث افزایش چشمگیر سرعت پردازش میشود.

۴. اوپنسورس بودن و جامعه فعال توسعهدهنده

LocalAI یک پروژه متنباز است. این یعنی کد آن آزادانه در دسترس است و جامعهای گسترده از توسعهدهندگان در سراسر دنیا بهطور مداوم در حال بهبود و توسعه آن هستند. این ویژگی علاوه بر شفافیت و امنیت بیشتر، امکان افزودن قابلیتهای سفارشی و مشارکت در توسعه پروژه را برای کاربران فراهم میکند.

مزایا و معایب استفاده از LocalAI

استفاده از LocalAI مثل هر فناوری دیگری، هم نقاط قوت دارد و هم محدودیتهایی که باید در نظر گرفته شوند. آشنایی با این موارد کمک میکند تصمیم بگیرید آیا این ابزار برای نیازهای شما مناسب است یا خیر.

مزایا:

۱. عدم نیاز به اینترنت یا ارسال داده به سرور خارجی

وقتی از LocalAI استفاده میکنید، تمام پردازشها روی سرور شخصی یا مجازی شما انجام میشود. این یعنی دادههای حساس یا محرمانه شما به هیچ سرور خارجی ارسال نمیشود. در نتیجه حریم خصوصی و امنیت اطلاعات بهطور کامل حفظ خواهد شد؛ موضوعی که برای شرکتها و سازمانها اهمیت ویژهای دارد.

۲. هزینه صفر برای درخواستها

برخلاف سرویسهای ابری مثل OpenAI که برای هر درخواست هزینه دریافت میکنند، LocalAI اوپنسورس و رایگان است. پس از نصب و راهاندازی، میتوانید بدون محدودیت تعداد درخواستها، از آن استفاده کنید. تنها هزینه شما مربوط به سرور یا سختافزار خواهد بود، نه مصرف API.

۳. امکان سفارشیسازی و استفاده از مدلهای دلخواه

LocalAI به شما اجازه میدهد مدلهای مختلف مثل LLaMA، Mistral یا Falcon را انتخاب و اجرا کنید. همچنین میتوانید تنظیمات دلخواه خودتان را روی مدلها اعمال کنید. این انعطافپذیری برای توسعهدهندگانی که به ویژگیهای خاص نیاز دارند بسیار ارزشمند است.

معایب:

۱. نیاز به سختافزار قوی برای مدلهای بزرگ

هرچه مدل انتخابی شما بزرگتر باشد (مثلاً مدلهای 13B یا 70B)، منابع سختافزاری بیشتری نیاز خواهید داشت. اجرای این مدلها روی یک VPS با رم یا CPU محدود ممکن است کند یا حتی غیرممکن باشد. برای استفاده حرفهای معمولاً به GPUهای قدرتمند نیاز است.

۲. پیچیدگی در نصب اولیه

اگرچه مستندات LocalAI کامل است، اما راهاندازی آن برای کاربران مبتدی میتواند کمی پیچیده باشد. مراحل نصب Docker، دانلود مدلها، و تنظیم API نیازمند دانش فنی اولیه است. به همین دلیل ممکن است در شروع کمی زمانبر باشد.

۳. سرعت پایینتر نسبت به سرویسهای ابری آماده

سرویسهایی مثل OpenAI از زیرساختهای ابری قدرتمند با GPUهای متعدد استفاده میکنند. در حالی که اجرای LocalAI روی یک سرور مجازی معمولی نمیتواند به همان سرعت پاسخگو باشد. برای پروژههای تجاری با ترافیک بالا، این تفاوت سرعت میتواند یک محدودیت محسوب شود.

نتیجه این است که LocalAI برای کسانی مناسب است که به حریم خصوصی، کنترل دادهها و کاهش هزینه اهمیت میدهند، حتی اگر کمی پیچیدگی فنی و سختافزاری را بپذیرند.

چه سروری برای LocalAI مناسب است؟

انتخاب سرور برای اجرای LocalAI به نوع مدل، منابع سختافزاری و میزان انتظاری که از سرعت و کیفیت پاسخ دارید وابسته است. هرچه مدل بزرگتر باشد، نیاز به سختافزار قدرتمندتر نیز افزایش پیدا میکند. به طور کلی میتوان سه سطح اصلی در نظر گرفت:

۱. مدلهای سبک (۷B)

برای شروع و اجرای مدلهای سبک مانند ۷B، یک سرور مجازی (VPS یا VDS) با حداقل ۸ گیگابایت رم و چند هسته پردازنده کافی خواهد بود. این پیکربندی بیشتر برای آزمایش، توسعه اولیه یا چتباتهای کوچک مناسب است.

اگر قصد دارید چند کاربر همزمان از سرویس استفاده کنند یا پاسخها روانتر ارائه شوند، بهتر است از سروری با ۱۶ گیگابایت رم استفاده کنید.

این مدلها را میتوان تنها با CPU اجرا کرد، هرچند استفاده از GPU سرعت و کیفیت را بهطور چشمگیری افزایش میدهد.

۲. مدلهای متوسط (۱۳B)

مدلهای ۱۳B کیفیت بالاتری نسبت به ۷B دارند اما به منابع بیشتری نیازمندند. در حالت CPU، بهتر است سرور حداقل ۱۶ تا ۲۴ گیگابایت رم داشته باشد تا از کندی بیش از حد جلوگیری شود.

برای استفاده حرفهایتر و دریافت پاسخ روان، یک GPU با حداقل ۱۶ گیگابایت حافظه گرافیکی (VRAM) مانند NVIDIA T4 یا A10 توصیه میشود. این سطح برای تیمها و کسبوکارهایی که به خروجی دقیقتر نیاز دارند گزینهای ایدهآل است.

۳. مدلهای سنگین (۷۰B)

مدلهای بزرگ مانند ۷۰B تنها برای سناریوهای سازمانی یا پژوهشی مناسب هستند. اجرای این مدلها روی CPU عملاً به دلیل کندی و مصرف بالای رم کاربردی نیست.

برای راهاندازی مؤثر این مدلها، به GPUهای دیتاسنتری با ۴۰ تا ۸۰ گیگابایت حافظه گرافیکی (مانند NVIDIA A100) یا حتی چند GPU متصل به هم نیاز دارید. این گزینه بیشتر برای مراکز داده و پروژههای تخصصی پیشنهاد میشود، نه برای استفاده عمومی روی یک VPS معمولی.

سایر ملاحظات

-

فضای ذخیرهسازی: مدلهای سبک حدود ۳ تا ۵ گیگابایت، مدلهای متوسط ۷ تا ۱۰ گیگابایت و مدلهای سنگین تا ۵۰ گیگابایت یا بیشتر فضا نیاز دارند. استفاده از دیسک NVMe بهدلیل سرعت بالا توصیه میشود.

-

سیستمعامل و نرمافزار: بهترین انتخاب برای اجرای پایدار LocalAI، Ubuntu 22.04 LTS به همراه Docker است. در صورت استفاده از GPU باید درایورهای NVIDIA و CUDA نیز نصب شوند.

-

شبکه: برای ارائه سرویس داخلی، پهنای باند ۱Gbps کافی است. سرعت بالاتر بیشتر در هنگام دانلود مدلها اهمیت دارد.

برای شروع کار با LocalAI و اجرای مدلهای سبک، یک سرور مجازی با ۸ تا ۱۶ گیگابایت رم کافی است. اگر کیفیت و سرعت بالاتر مدنظر شماست، پیشنهاد میشود از مدلهای متوسط همراه با GPU اختصاصی استفاده کنید. مدلهای بسیار بزرگ مانند ۷۰B تنها در شرایط خاص و روی زیرساختهای پیشرفته دیتاسنتری قابل استفاده هستند.

آموزش نصب روی سرور مجازی

راهاندازی آن روی سرور مجازی (VPS یا VDS) فرآیندی نسبتاً ساده است و میتوان آن را تنها در چند مرحله انجام داد. در این آموزش از Docker استفاده میکنیم تا نصب و اجرا بدون پیچیدگیهای اضافی صورت گیرد.

۱. نصب پیشنیازها

ابتدا مطمئن شوید که روی سرور شما Docker و Docker Compose نصب است. اگر نصب نیست، میتوانید از دستورات زیر (برای Ubuntu 22.04) استفاده کنید:

sudo apt update && sudo apt upgrade -y sudo apt install -y docker.io docker-compose sudo systemctl enable docker sudo systemctl start docker

۲. دانلود و آمادهسازی

سپس مخزن رسمی LocalAI را کلون کنید:

git clone https://github.com/go-skynet/LocalAI.git cd LocalAI

یا اگر نمیخواهید سورسکد را کلون کنید، میتوانید مستقیماً از ایمیج Docker استفاده کنید:

docker pull localai/localai:latest

۳. دانلود مدل هوش مصنوعی

برای شروع، بهتر است از یک مدل سبک مانند Mistral-7B استفاده کنید. مدلها به فرمت GGUF منتشر میشوند و باید آنها را در مسیر مشخص قرار دهید. بهعنوان نمونه:

mkdir -p models cd models wget https://huggingface.co/TheBloke/Mistral-7B-Instruct-GGUF/resolve/main/mistral-7b-instruct.Q4_K_M.gguf

این فایل مدل را در پوشه models ذخیره میکنیم.

۴. اجرا با Docker

حالا میتوانید LocalAI را با دستور زیر اجرا کنید و پوشهی مدلها را به آن معرفی نمایید:

docker run -it --rm -p 8080:8080 \ -v $(pwd)/models:/models \ -e MODELS_PATH=/models \ localai/localai:latest

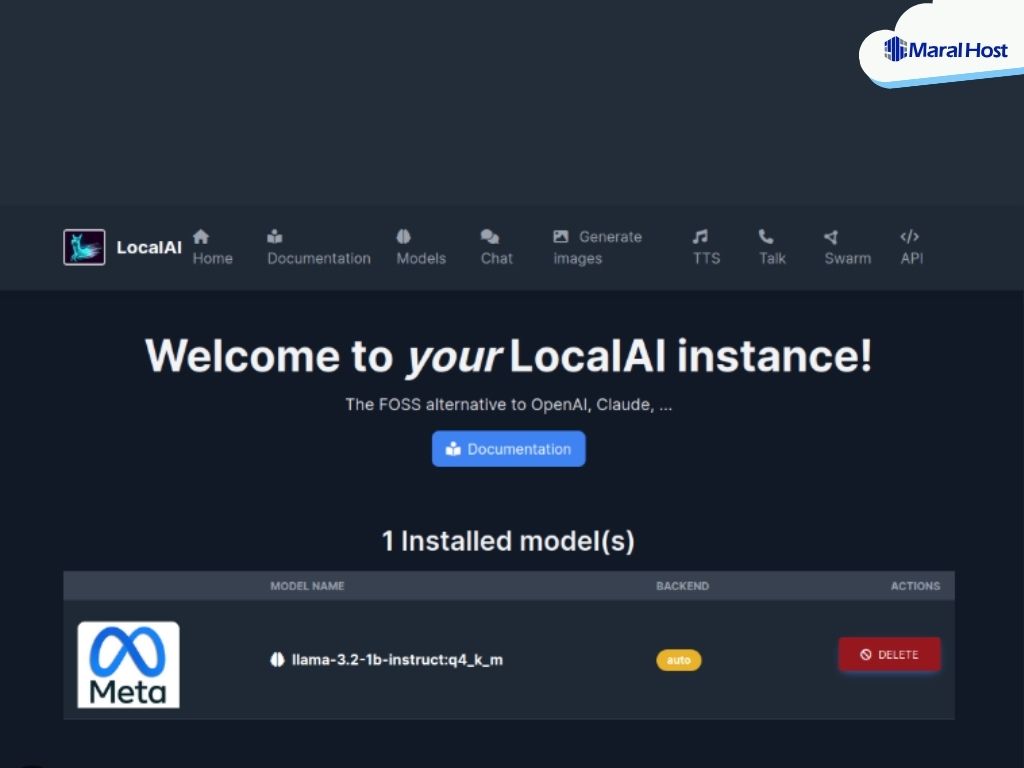

اکنون LocalAI روی پورت 8080 در دسترس است.

۵. تست API با Curl

برای اطمینان از عملکرد صحیح، یک درخواست ساده به API ارسال کنید:

curl http://localhost:8080/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "mistral-7b-instruct.Q4_K_M.gguf",

"messages": [{"role":"user","content":"سلام! LocalAI چیست؟"}]

}'

اگر همهچیز درست انجام شده باشد، پاسخی مشابه ChatGPT دریافت خواهید کرد.

۶. استفاده با Python

میتوانید آن را دقیقاً مانند OpenAI API در کد Python استفاده کنید. برای این کار کافی است کلاینت OpenAI را نصب کنید و آدرس سرور خود را بهعنوان endpoint تعریف نمایید:

from openai import OpenAI

client = OpenAI(base_url="http://localhost:8080/v1", api_key="not-needed")

resp = client.chat.completions.create(

model="mistral-7b-instruct.Q4_K_M.gguf",

messages=[{"role": "user", "content": "یک توضیح کوتاه درباره LocalAI بده"}]

)

print(resp.choices[0].message.content)

با این مراحل ساده، شما این برنامه را روی سرور مجازی خود راهاندازی کرده و از آن درست مانند APIهای OpenAI استفاده کنید. تنها تفاوت این است که همه پردازشها بهصورت محلی انجام میشوند و نیازی به پرداخت هزینه یا ارسال داده به سرورهای خارجی ندارید.

موارد استفاده از این ابزار

این ابزار بهدلیل سازگاری کامل با ساختار APIهای هوش مصنوعی، قابلیتهای متنوعی را در اختیار کاربران قرار میدهد و میتواند در سناریوهای مختلف مورد استفاده قرار گیرد:

۱. اجرای چتبات روی سرور شخصی

امکان راهاندازی یک چتبات پیشرفته مشابه ChatGPT وجود دارد که میتواند برای پشتیبانی مشتریان، پاسخ به پرسشهای متداول یا حتی تعامل درونی سازمان مورد استفاده قرار گیرد. تمامی دادهها در بستر داخلی پردازش میشوند و کنترل کامل بر حریم خصوصی حفظ خواهد شد.

۲. یکپارچهسازی با اپلیکیشنها و وبسایتها

از آنجا که رابط برنامهنویسی این سیستم مشابه OpenAI طراحی شده است، توسعهدهندگان میتوانند بدون تغییر در کدهای موجود، آن را به برنامهها یا وبسایتهای خود متصل کنند. این موضوع باعث میشود مهاجرت از سرویسهای تجاری به بستر شخصی بهسادگی انجام شود.

۳. پردازش متن و تولید محتوا

علاوه بر قابلیتهای گفتوگومحور، امکان تحلیل متن، تولید محتوای متنی، خلاصهسازی و حتی ایجاد Embedding برای بهبود جستجو و دستهبندی دادهها نیز فراهم است. این ویژگیها در موتورهای جستجوی سفارشی، سیستمهای مدیریت محتوا و ابزارهای تحقیقاتی کاربرد فراوان دارند.

۴. تبدیل صدا به متن

با بهرهگیری از مدل Whisper میتوان فایلهای صوتی یا مکالمات زنده را به متن تبدیل کرد. این قابلیت برای پیادهسازی دستیارهای صوتی، ابزارهای یادداشتبرداری خودکار و همچنین زیرنویسگذاری در ویدئوها بسیار مفید است.

مقایسه با سرویسهای مشابه

مقایسه با n8n (اتوماسیون)

-

هدف اصلی:

n8n یک پلتفرم خودکارسازی و گردش کار (workflow) است؛ برای مثال ارسال ایمیل، پردازش داده، Trigger-های بر اساس رویدادها، ادغام سرویسها. نه بهصورت تخصصی اجرا مدل هوش مصنوعی. در مقابل، تمرکز بیشتر بر پردازش LLM و API هوش مصنوعی دارد. -

سهولت یکپارچهسازی:

در n8n میتوان nodeهایی تعریف کرد که به API خارجی OpenAI متصل شود یا به API محلی شبیه اتصال به یک سرور مدل محلی. اما برای اضافه کردن مدل محلی نیاز به تنظیمات بیشتری است. سرویس تخصصیتر در زمینهی مدل هوش مصنوعی معمولاً سادهتر اجازه میدهد مدل را لود، اجرا و پاسخ بگیرد. -

قابلیتها:

n8n عالی است برای طراحی گردش کار (workflow) بصری، متصل کردن سرویسهای متعدد، اتوماسیون کسبوکار، ارسال هشدار، واکنش به رویدادها. اما وقتی میخواهی مدل هوش مصنوعی را با کنترل دقیق بر تنظیمات مدل، کمّیسازی، نوع backend و قالب پاسخدهی داشته باشی، گزینه تخصصیتر در این حوزه بهتر عمل میکند.

مقایسه با Ollama (تمرکز روی مدلهای LLaMA)

-

سهولت نصب و راهاندازی:

Ollama معمولاً نصب سریع دارد و کاربردش ساده است. مدلها را میتوان با دستورات کم دانلود کرد، رابط کاربری ساده دارد و برای کاربرانی که میخواهند زود مدلها را تست کنند مناسب است. سرویس تخصصی هوش مصنوعی با تمرکز بیشتر روی مدل لود، quantization، تنظیمات backend و شخصیسازی، بیشتر مناسب کسانی است که کنترل بیشتری میخواهند. -

پشتیبانی سختافزاری:

Ollama معمولاً به GPU ترجیح میدهد تا عملکرد بهتری بدهد و تجربهی روانتری فراهم کند. اما گزینههایی که بتوانند با CPU هم کار کنند و در محیطهایی که GPU ندارند قابل استفاده باشند، برتری دارند برای پروژههای کمهزینه یا محیطهایی که سختافزار قوی دردسترس نیست. -

تنوع مدلها و فرمتها:

Ollama کتابخانهای از مدلهای شناختهشده دارد و فرمتهایی که تأیید شدهاند را عرضه میکند. اما اگر بخواهی مدلهای سفارشی یا فرمتهایی که کمتر رایجاند را وارد کنی یا backendهای متفاوتی داشته باشی، گزینه منعطفتر که بتواند با فرمتها و مدلهای متنوع کار کند، بهتر است. -

تجربه توسعهدهنده:

Ollama تجربهی کاربری خوبی دارد؛ اما برای توسعهدهندهای که میخواهد ابزارها، SDKها، کدهایی که برای OpenAI نوشتهاند را با کمترین تغییر استفاده کند، سرویس تخصصیتری که امکان تطبیق API دارد و بتواند راحتتر به سیستم موجود وصل شود مزیت دارد.

چرا گزینه مذکور برای توسعهدهندهها جذابتر است؟

با در نظر گرفتن مقایسهها، این دلایل نشان میدهد چرا برای توسعهدهندهها ممکن است گزینهای که انعطاف، کنترل و سازگاری بیشتری دارد، جذابتر باشد:

-

سازگاری API با کدهای موجود

اگر پیشتر از APIهایی مشابه OpenAI در پروژهها استفاده کرده باشی، استفاده از سیستمی که API آن تقریباً یکسان است باعث میشود نیازی به بازنویسی زیاد نباشد. این یعنی مهاجرت سریعتر و دردسر کمتر. -

انعطاف در انتخاب مدل، فرمت و backend

توانایی استفاده از مدلهای متفاوت، کمّیسازی، فرمتهای مختلف، حتی کنترل بر اجرای på GPU یا CPU، همه امکاناتیاند که قدرت مانور توسعهدهنده را افزایش میدهند. -

حفظ حریم خصوصی و کنترل دادهها

وقتی اجرا روی سرور خودتان است، دادهها به بیرون ارسال نمیشوند؛ بخصوص در پروژههایی که داده حساس، محرمانه یا نیاز به رعایت مقررات حریم خصوصی دارد، این نکته بسیار حیاتی است. -

کاهش هزینهها در بلندمدت

اگر بار استفاده زیاد است یا تعداد درخواستها زیاد است، هزینه پرداخت برای APIهای تجاری زیاد میشود. راهاندازی محلی با هزینهی اولیهی سختافزاری میتواند در بلندمدت بسیار مقرونبهصرفهتر باشد. -

قابلیت سفارشیسازی و توسعه مداوم

برای توسعهدهندهها همیشه مهم است که بتوانند بخشی را تغییر دهند، تنظیمات مدل را دستکاری کنند، نسخههای جدید مدلها را اضافه کنند یا ویژگیهای جدیدی مثل پردازش صوتی یا تصویر را بیفزایند. دستیابی به اینها در سرویسهایی که بستهتر هستند، دشوار است. -

مستقل بودن از قطعیها و محدودیتهای زیرساخت خارجی

اعتماد به سرویس ابری یعنی به زیرساخت دیگران وابسته بودن؛ در وقتی که اینترنت مشکل دارد، یا شرکت میزبان هزینهها را زیاد میکند، یا API محدودیت میگذارد، داشتن سیستم محلی به توسعهدهنده آرامش بیشتری میدهد.

جمعبندی

فناوریهای نوین هوش مصنوعی دیگر محدود به سرویسهای ابری تجاری نیستند. با ظهور ابزارهایی مانند LocalAI، امکان اجرای مدلهای زبانی پیشرفته بر روی سرورهای شخصی یا مجازی فراهم شده است. این راهکار علاوه بر کاهش هزینههای مرتبط با APIهای خارجی، کنترل کامل بر دادهها و حفظ حریم خصوصی را نیز به همراه دارد.

در طول مقاله دیدیم که این ابزار از سازگاری کامل با APIهای OpenAI برخوردار است، از مدلهای متنوعی مانند LLaMA و Mistral پشتیبانی میکند و حتی قابلیت استفاده در حوزههایی چون چتباتها، پردازش متن، جستجو و تبدیل صدا به متن را دارد. در مقابل، برای اجرای مدلهای بزرگ نیازمند منابع سختافزاری قدرتمند و راهاندازی اولیهی نسبتاً پیچیدهای است.

با این حال، مزایای آن برای توسعهدهندگان و کسبوکارهایی که به استقلال، سفارشیسازی و امنیت داده اهمیت میدهند، بهمراتب بیشتر از محدودیتهایش است. بنابراین میتوان گفت استفاده از چنین راهکاری انتخابی هوشمندانه برای کسانی است که میخواهند از قدرت مدلهای زبانی مدرن بهره ببرند، بدون آنکه به زیرساختهای خارجی وابسته باشند.