فهرست محتوا

- 1 مقدمه:

- 2

- 3 روند اول: افزایش تقاضای انرژی دیتاسنترها

- 4 روند دوم: خنکسازی مایع و سرمایش مستقیم تراشه (Direct-to-Chip)

- 5 روند سوم: رشد دیتاسنترهای ابرمقیاس (Hyperscale)

- 6 روند چهارم: گسترش دیتاسنترهای لبه (Edge Data Centers)

- 7 روند پنجم: زیرساختهای مخصوص هوش مصنوعی

- 8 روند ششم: ورود رایانش کوانتومی به نقشه Data Center

- 9 روند هفتم: توسعه در بازارهای جدید و مناطق کمتر شناختهشده

- 10 روند هشتم: گاز طبیعی و نقش آن بهعنوان پل انرژی

- 11 جمعبندی

مقدمه:

DataCenter قلب تپنده اقتصاد دیجیتال امروز است. هر کلیک، جستجو، خرید آنلاین یا حتی تماشای یک ویدئو در شبکههای اجتماعی، به پشتوانه مراکز داده انجام میشود. با رشد سریع فناوریهایی مانند هوش مصنوعی، اینترنت اشیا، 5G و کلانداده، نیاز به پردازش و ذخیرهسازی اطلاعات به شکلی بیسابقه افزایش یافته است. همین موضوع باعث شده DataCenter نه تنها زیرساختی فنی، بلکه یکی از ارکان حیاتی اقتصاد جهانی به شمار روند.

سال ۲۰۲۵ نقطه عطفی برای این صنعت خواهد بود؛ زیرا تغییرات بنیادین در حوزه انرژی، طراحی سختافزار، شبکه و حتی مکانیابی مراکز داده در راه است. در این مقاله به بررسی ۸ روند کلیدی میپردازیم که آینده DataCenter را در سال ۲۰۲۵ شکل خواهند داد و مسیر تحول این صنعت استراتژیک را ترسیم میکنند.

روند اول: افزایش تقاضای انرژی دیتاسنترها

دیتاسنترها همیشه مصرفکنندههای بزرگ انرژی بودهاند، اما ورود فناوریهای نوین باعث شده این مصرف برق در سالهای اخیر به شکل تصاعدی افزایش پیدا کند. دو عامل اصلی در این تغییر نقش دارند: رشد پردازشهای مربوط به هوش مصنوعی و افزایش حجم کلاندادهها (Big Data).

برای اجرای مدلهای پیشرفته هوش مصنوعی، هزاران پردازش همزمان روی کارتهای گرافیک (GPU) و تراشههای خاص انجام میشود. این تراشهها نسبت به CPUهای سنتی توان بیشتری دارند اما در مقابل، انرژی بسیار بیشتری هم مصرف میکنند. وقتی این موضوع در مقیاس DataCenter بزرگ یا ابرمقیاس (Hyperscale) اتفاق میافتد، نتیجه آن جهشی چشمگیر در مصرف برق خواهد بود.

از طرف دیگر، ذخیرهسازی و تحلیل کلاندادهها نیازمند رکهای متعدد سرور و تجهیزات ذخیرهسازی است. این تجهیزات هم بهطور مداوم در حال کار هستند و انرژی زیادی برای روشن ماندن، پردازش و خنکسازی مصرف میکنند.

این رشد مصرف انرژی فشار قابل توجهی بر منابع انرژی پایدار وارد کرده است. بسیاری از DataCenterها برای کاهش ردپای کربنی خود به سمت انرژیهای تجدیدپذیر مثل خورشیدی و بادی رفتهاند، اما سرعت افزایش تقاضا به قدری بالاست که زیرساختهای انرژی سبز هنوز نمیتوانند بهطور کامل پاسخگو باشند. همین موضوع، صنعت دیتاسنتر را در برابر چالش بزرگی قرار داده: چگونه میتوان رشد فناوری را ادامه داد و در عین حال پایداری محیطزیستی را حفظ کرد؟

روند دوم: خنکسازی مایع و سرمایش مستقیم تراشه (Direct-to-Chip)

یکی از بزرگترین چالشهای DataCenterهای مدرن، مدیریت گرمای تولیدشده توسط سرورهاست. هرچه توان پردازشی بالاتر میرود، مصرف برق بیشتر میشود و در نتیجه حرارت بیشتری هم ایجاد میگردد. در گذشته، بیشتر مراکز داده با استفاده از سیستمهای تهویه مطبوع (Air Cooling) و جریان هوای سرد، دما را کنترل میکردند. اما این روش سنتی دیگر برای بارهای کاری امروزی، بهویژه در حوزه هوش مصنوعی و پردازشهای سنگین، کافی نیست.

چرا خنکسازی سنتی جواب نمیدهد؟

سیستمهای خنکسازی مبتنی بر هوا محدودیتهای جدی دارند. هوا رسانایی کمی برای انتقال حرارت دارد و برای پایین آوردن دمای سرورها نیاز است حجم زیادی از هوا جابهجا شود. این یعنی فنهای پرقدرت، کانالهای بزرگ، و مصرف انرژی بالا. وقتی رکهای سرور با تراکم بالا و تراشههای پرمصرف GPU پر میشوند، هوا بهتنهایی قادر نیست حرارت را بهسرعت از بین ببرد. نتیجه آن افزایش دما، افت راندمان سختافزار و حتی خطر خرابی تجهیزات است.

راهحل: خنکسازی مایع و Direct-to-Chip

به همین دلیل، DataCenterهای پیشرو به سمت خنکسازی مایع (Liquid Cooling) حرکت کردهاند. در این روش، بهجای تکیه صرف بر هوا، از مایعاتی با ظرفیت بالای انتقال حرارت استفاده میشود. دو مدل رایج وجود دارد:

-

غوطهوری کامل (Immersion Cooling): در این روش، کل سرور یا بخشی از آن در مایع دیالکتریک غوطهور میشود. این مایع بدون ایجاد رسانایی الکتریکی، گرما را جذب کرده و به سیستم خنککننده منتقل میکند.

-

سرمایش مستقیم تراشه (Direct-to-Chip): در این مدل، مایع خنککننده از طریق لولهها مستقیماً به سطح پردازندهها و GPUها منتقل میشود. گرما بلافاصله از سطح تراشه به مایع منتقل شده و سپس به خارج هدایت میگردد.

مزیتهای خنکسازی مایع برای دیتاسنترهای بزرگ

مزیتهای این فناوری بسیار چشمگیر است:

-

کارایی بالاتر در انتقال حرارت: مایع میتواند تا هزار برابر مؤثرتر از هوا گرما را منتقل کند. این یعنی سرورها میتوانند در دمای بهینه و بدون خطر بیشگرمایی کار کنند.

-

کاهش مصرف انرژی: خنکسازی مایع انرژی کمتری نسبت به سیستمهای مبتنی بر هوا مصرف میکند. این موضوع برایDataCenterهای بزرگ، که هزینه برق در آنها سرسامآور است، اهمیت حیاتی دارد.

-

امکان افزایش تراکم سرورها: با حذف محدودیتهای جریان هوا، میتوان رکها را با تراکم بالاتری پر کرد. این یعنی در همان فضای فیزیکی، توان پردازشی بیشتری ارائه میشود.

-

دوام بیشتر سختافزار: خنکسازی دقیق و پایدار باعث میشود قطعات الکترونیکی در دمای ثابت کار کنند و عمر بیشتری داشته باشند.

-

پایداری محیطزیستی: کاهش مصرف انرژی برای خنکسازی و بهبود بهرهوری، به کاهش ردپای کربنی DataCenterها کمک میکند.

آینده خنکسازی مایع

با توجه به رشد روزافزون هوش مصنوعی و نیاز به GPUهای قدرتمند، پیشبینی میشود که در سال ۲۰۲۵ و پس از آن، خنکسازی مایع و Direct-to-Chip از یک انتخاب لوکس به یک ضرورت حیاتی تبدیل شوند. شرکتهای بزرگ فناوری در حال سرمایهگذاری گسترده روی این حوزه هستند و به احتمال زیاد، ظرف چند سال آینده این روش به استاندارد اصلی DataCenterهای پیشرفته تبدیل خواهد شد.

روند سوم: رشد دیتاسنترهای ابرمقیاس (Hyperscale)

یکی از مهمترین تحولات صنعت DataCenter در سالهای اخیر، ظهور و گسترش دیتاسنترهای ابرمقیاس (Hyperscale Data Centers) بوده است. این مراکز داده بهطور ویژه توسط غولهای فناوری مانند آمازون (AWS)، گوگل (Google Cloud) و مایکروسافت (Azure) طراحی و اداره میشوند و هدف اصلی آنها پشتیبانی از مقیاس عظیمی از پردازشها و خدمات ابری است.

چرا دیتاسنترهای ابرمقیاس اهمیت دارند؟

با رشد سریع سرویسهای ابری، هوش مصنوعی، و اینترنت اشیا، نیاز به توان پردازشی و ذخیرهسازی داده روزبهروز بیشتر میشود. دیتاسنترهای سنتی توان پاسخگویی به چنین حجم عظیمی از تقاضا را ندارند. در مقابل، دیتاسنترهای ابرمقیاس با هزاران و حتی میلیونها سرور طراحی شدهاند تا بتوانند این حجم از پردازش و ذخیرهسازی را بهصورت کارآمد مدیریت کنند.

نقش شرکتهای بزرگ

-

آمازون (AWS): بهعنوان بزرگترین ارائهدهنده خدمات ابری جهان، دیتاسنترهای ابرمقیاس AWS ستون فقرات بسیاری از استارتاپها، اپلیکیشنها و حتی سازمانهای دولتی هستند.

-

گوگل (Google Cloud): با سرمایهگذاری سنگین در حوزه AI و Big Data، گوگل DataCenter خود را بهگونهای طراحی کرده که بتوانند سریعترین پاسخ را به پردازشهای یادگیری ماشینی بدهند.

-

مایکروسافت (Azure): تمرکز مایکروسافت روی یکپارچهسازی سرویسهای ابری با نرمافزارهای سازمانی و ویندوز باعث شده DataCenter جایگاه ویژهای در بازار شرکتها و سازمانهای بزرگ پیدا کنند.

ویژگیهای کلیدی DataCenterهای ابرمقیاس

-

ظرفیت پردازشی عظیم: این مراکز داده قادرند میلیونها درخواست همزمان را پردازش کنند.

-

مقیاسپذیری سریع: در صورت افزایش ناگهانی تقاضا، بهسرعت میتوان ظرفیت پردازشی و ذخیرهسازی را افزایش داد.

-

بهرهوری بالا: با استفاده از طراحی پیشرفته، مصرف انرژی و هزینههای عملیاتی بهینه میشوند.

-

زیرساخت مناسب برای AI و Cloud: معماری این DataCenterها از ابتدا برای کار با بارهای سنگین ابری و پردازشهای هوش مصنوعی طراحی شده است.

حرکت به سمت آینده

رشد دیتاسنترهای ابرمقیاس فقط یک روند فناورانه نیست، بلکه یک تحول اقتصادی و استراتژیک به شمار میآید. دولتها و شرکتهای بزرگ در حال سرمایهگذاری برای جذب این دیتاسنترها به کشورها و شهرهای خود هستند، زیرا حضور یکDataCenterابرمقیاس میتواند به معنای توسعه اقتصادی، ایجاد اشتغال و افزایش جایگاه رقابتی آن منطقه باشد.

پیشبینی میشود تا سال ۲۰۲۵، تعداد دیتاسنترهای ابرمقیاس در جهان از مرز ۱۰۰۰ مرکز فعال عبور کند و بخش عمدهای از پردازشهای جهانی در همین مراکز متمرکز شود.

روند چهارم: گسترش دیتاسنترهای لبه (Edge Data Centers)

وقتی دربارهDataCenter صحبت میکنیم، اغلب مراکزی بزرگ و متمرکز در نظرمان میآید که هزاران سرور را در یک مکان مستقر کردهاند. اما با رشد فناوریهای نوین، این مدل متمرکز دیگر برای همه نیازها کارآمد نیست. همین مسئله باعث شده دیتاسنترهای لبه (Edge Data Centers) به یکی از مهمترین روندهای صنعت در سال ۲۰۲۵ تبدیل شوند.

چرا پردازش نزدیک به کاربر اهمیت دارد؟

در بسیاری از کاربردها، زمان پاسخگویی یا همان تأخیر (Latency) اهمیت حیاتی دارد. تصور کنید در یک خودروی خودران، فرمان ترمز باید در کسری از ثانیه اجرا شود یا در یک جراحی رباتیک از راه دور، هر میلیثانیه تأخیر میتواند خطرناک باشد. اگر تمام دادهها برای پردازش به یک DataCenter مرکزی در هزاران کیلومتر آنطرفتر ارسال شوند، این تأخیر اجتنابناپذیر خواهد بود.

اینجاست که دیتاسنترهای لبه وارد عمل میشوند. این مراکز داده کوچکتر و پراکنده، بهجای استقرار در یک نقطه مرکزی، در نزدیکی کاربران و دستگاهها قرار میگیرند. با این کار، دادهها در همان محل یا نزدیکترین نقطه پردازش میشوند و فقط اطلاعات نهایی یا ضروری به دیتاسنترهای مرکزی ارسال میگردد.

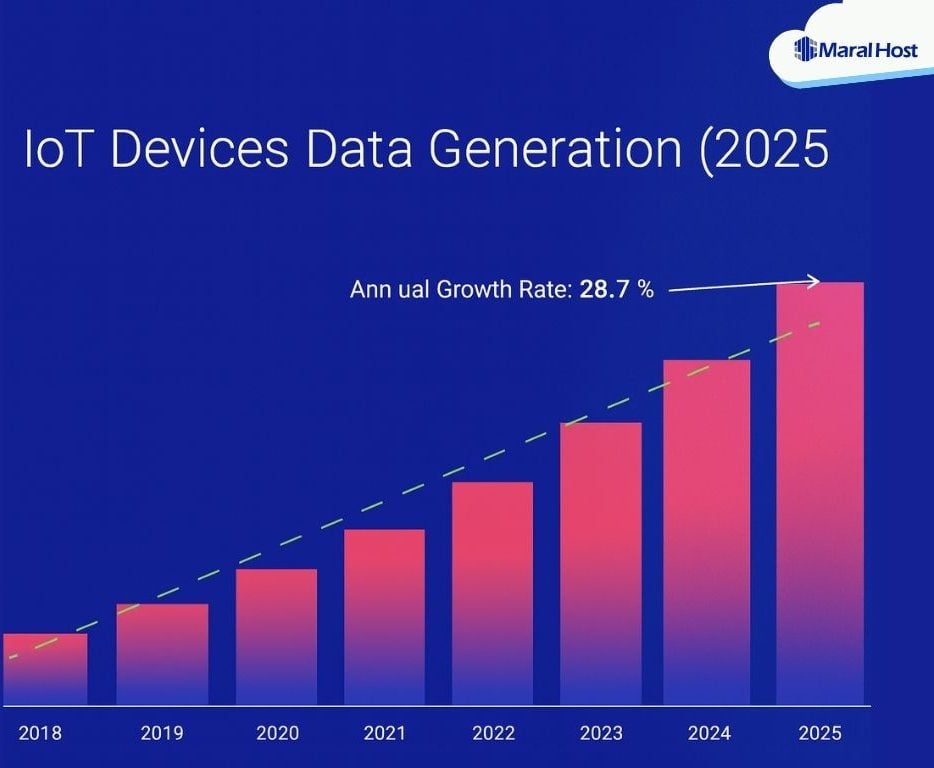

کاربردها در اینترنت اشیا (IoT) و 5G

-

اینترنت اشیا (IoT): میلیاردها دستگاه هوشمند مانند سنسورها، دوربینهای شهری، تجهیزات صنعتی و وسایل خانگی هوشمند هر لحظه در حال تولید داده هستند. انتقال همه این دادهها به DataCenterهای مرکزی نهتنها زمانبر، بلکه پرهزینه است. پردازش در لبه باعث میشود تصمیمگیری سریعتر و محلیتر انجام شود.

-

شبکه 5G: یکی از بزرگترین وعدههای 5G کاهش تأخیر ارتباطات به کمتر از یک میلیثانیه است. تحقق این وعده بدون وجود DataCenterهای لبه ممکن نیست. به همین دلیل اپراتورهای مخابراتی در حال سرمایهگذاری گسترده برای ایجاد مراکز داده نزدیک به آنتنهای 5G هستند.

مزیتهای اصلی DataCenterهای لبه

-

کاهش تأخیر: دادهها در همان محل تولید پردازش میشوند.

-

کاهش پهنای باند مصرفی: فقط دادههای ضروری به دیتاسنترهای مرکزی منتقل میشوند.

-

امنیت و حریم خصوصی بیشتر: اطلاعات حساس میتوانند در همان نقطه باقی بمانند و نیازی به انتقال به مسافتهای طولانی ندارند.

-

مقیاسپذیری بهتر: بهجای فشار بر مراکز داده مرکزی، بار پردازش در سطح شبکه توزیع میشود.

آینده دیتاسنترهای لبه

با رشد خودروهای خودران، شهرهای هوشمند، واقعیت افزوده (AR/VR) و کاربردهای صنعتی اینترنت اشیا، تقاضا برای DataCenterهای لبه در سال ۲۰۲۵ بهشدت افزایش خواهد یافت. پیشبینی میشود این مراکز داده به بخشی جدانشدنی از اکوسیستم فناوری تبدیل شوند و مانند DataCenterهای مرکزی، نقش حیاتی در تجربه دیجیتال روزمره ما ایفا کنند.

روند پنجم: زیرساختهای مخصوص هوش مصنوعی

هوش مصنوعی در چند سال اخیر از یک فناوری آزمایشی به موتور محرک اصلی صنعت فناوری تبدیل شده است. از چتباتها و دستیارهای هوشمند گرفته تا مدلهای یادگیری عمیق برای تشخیص تصویر و پردازش زبان طبیعی، همه و همه نیازمند توان پردازشی عظیم هستند. این تغییرات باعث شده DataCenterها دیگر نتوانند با معماری سنتی خود ادامه دهند و به سمت زیرساختهایی مخصوص پردازشهای AI حرکت کنند.

اهمیت GPU و تراشههای ویژه در پردازش AI

در گذشته بیشتر پردازشها بر دوش CPUها بود. اما الگوریتمهای یادگیری عمیق و مدلهای هوش مصنوعی امروزی به GPUها و تراشههای اختصاصی (مثل TPU گوگل یا چیپهای سفارشی انویدیا و AMD) نیاز دارند. GPUها توانایی اجرای هزاران عملیات موازی را دارند و همین ویژگی آنها را برای آموزش و اجرای مدلهای پیچیده هوش مصنوعی ایدهآل میکند.

با گسترش کاربرد AI، مجبور شدهاند رکهای خود را طوری طراحی کنند که بتوانند از تعداد زیادی GPU پشتیبانی کنند. این کار نهتنها مصرف انرژی و گرمای بیشتری ایجاد میکند (که خود نیازمند خنکسازی پیشرفته است)، بلکه طراحی شبکه و منبع تغذیه را هم تحت تأثیر قرار میدهد.

مطالعه بیشتر: تأثیر هوش مصنوعی بر مصرف برق مراکز داده و رشد پیشبینیشده

تغییر طراحی رکها و شبکهها برای AI

برای پشتیبانی از بارهای کاری AI، تغییرات عمدهای در DataCenterها در حال رخ دادن است:

-

رکهای پرقدرت (High-Density Racks): رکهایی با تراکم بالاتر سرورها که ظرفیت میزبانی تعداد زیادی GPU را دارند.

-

شبکههای پرسرعت: بارهای کاری هوش مصنوعی به تبادل حجم عظیمی از داده نیاز دارند. به همین دلیل استفاده از شبکههای با پهنای باند بالا مثل InfiniBand یا Ethernet با سرعت 400Gbps و بالاتر به یک ضرورت تبدیل شده است.

-

منابع تغذیه قویتر: GPUها مصرف برق بالایی دارند. طراحی جدید رکها باید بتواند بار الکتریکی بیشتر را بدون خطر ناپایداری تأمین کند.

-

خنکسازی پیشرفته: همانطور که در روند دوم اشاره شد، استفاده از خنکسازی مایع و Direct-to-Chip برای رکهای AI به سرعت در حال استاندارد شدن است.

آینده زیرساختهای AI در DataCenterها

با انفجار مدلهای مولد (Generative AI) مثل ChatGPT و DALL·E، پیشبینی میشود بخش قابل توجهی از ظرفیت DataCenterهای جهان به اجرای بارهای کاری هوش مصنوعی اختصاص یابد. بهعبارت دیگر، DataCenter آینده بیشتر شبیه یک “کارخانه پردازش AI” خواهد بود تا یک مرکز ذخیرهسازی داده سنتی.

برای همین، سرمایهگذاری در GPU، تراشههای سفارشی و طراحی شبکههای پرسرعت، در سال ۲۰۲۵ و بعد از آن، به یکی از محورهای اصلی استراتژی DataCenterها تبدیل خواهد شد.

روند ششم: ورود رایانش کوانتومی به نقشه Data Center

رایانش کوانتومی (Quantum Computing) هنوز در ابتدای مسیر قرار دارد، اما پتانسیل آن برای آینده صنعت فناوری انکارناپذیر است. برخلاف رایانش کلاسیک که تنها بر پایه صفر و یک عمل میکند، کوانتوم از کیوبیتها (Qubits) استفاده میکند؛ عناصری که میتوانند همزمان در چند حالت وجود داشته باشند. این ویژگی باعث میشود سیستمهای کوانتومی قادر باشند مسائلی را حل کنند که حتی قدرتمندترین ابرکامپیوترهای فعلی هم از عهده آن برنمیآیند.

جایگاه فعلی کوانتوم در جهان فناوری

در حال حاضر، رایانش کوانتومی بیشتر در مرحله تحقیق و توسعه است. شرکتهای پیشرو مانند IBM، گوگل، مایکروسافت و D-Wave نمونههای اولیه پردازندههای کوانتومی را معرفی کردهاند. این دستگاهها هنوز بهطور تجاری در دسترس نیستند، اما اهمیت آنها به قدری بالاست که بسیاری از شرکتهای فناوری زیرساختی، آینده خود را بر اساس آن طراحی میکنند.

سرمایهگذاریهای اولیه در زیرساخت ابری

چند بازیگر بزرگ صنعت شروع به سرمایهگذاری روی ادغام کوانتوم با پلتفرمهای ابری کردهاند:

-

گوگل با پروژه Sycamore نشان داد که یک پردازنده کوانتومی میتواند محاسباتی را میلیونها برابر سریعتر از رایانههای کلاسیک انجام دهد.

-

مایکروسافت در پلتفرم Azure سرویسهای شبیهسازی کوانتومی ارائه داده تا توسعهدهندگان از همین امروز بتوانند الگوریتمها و اپلیکیشنهای آینده را آزمایش کنند.

اثرات احتمالی بر طراحی مراکز پردازش داده

ورود فناوری کوانتوم تغییرات بنیادینی در معماری این مراکز ایجاد خواهد کرد:

-

خنکسازی خاص و پیشرفته: پردازندههای کوانتومی معمولاً نیاز به دماهایی نزدیک به صفر مطلق دارند. بنابراین استفاده از سیستمهای خنکسازی فوقالعاده پیچیده اجتنابناپذیر است.

-

همزیستی با پردازش کلاسیک: حداقل در آینده نزدیک، محاسبات کوانتومی جایگزین کامل سیستمهای سنتی نخواهد شد؛ بلکه در کنار آنها کار خواهد کرد. این یعنی طراحی محیطهای ترکیبی که بتوانند هر دو نوع پردازش را مدیریت کنند.

-

بازتعریف امنیت: توان بالای کوانتوم میتواند بسیاری از الگوریتمهای رمزنگاری فعلی را بشکند. به همین دلیل، از همین امروز باید به سمت رمزنگاری مقاوم در برابر کوانتوم (Post-Quantum Cryptography) حرکت کرد.

آینده کوانتوم در صنعت پردازش داده

اگرچه هنوز چند سال تا تجاریسازی گسترده کوانتوم فاصله داریم، اما سال ۲۰۲۵ میتواند نقطهای باشد که این فناوری به نقشه راه مراکز پردازش داده وارد شود. بهعبارت دیگر، زیرساختهای ابری و شبکههای آینده باید از همین حالا خودشان را برای ترکیب محاسبات کلاسیک و کوانتومی آماده کنند.

روند هفتم: توسعه در بازارهای جدید و مناطق کمتر شناختهشده

تا همین چند سال پیش، بیشتر DataCenterها در شهرهای بزرگ و مناطق پیشرفتهای مثل آمریکای شمالی و اروپای غربی متمرکز بودند. دلیلش هم روشن بود: دسترسی به زیرساخت برق پایدار، شبکه اینترنت پرسرعت، سرمایهگذاریهای کلان و تقاضای بالا. اما با رشد جهانی اقتصاد دیجیتال، این الگو در حال تغییر است.

تمرکززدایی از شهرهای بزرگ

فشار بیش از حد روی مناطق سنتی، مانند دوبلین در ایرلند یا ویرجینیا در ایالات متحده، مشکلاتی جدی به همراه آورده است؛ از کمبود زمین گرفته تا بحران مصرف انرژی. همین مسئله باعث شده شرکتهای بزرگ فناوری بهجای تمرکز بر چند نقطه محدود، به فکر توزیع جغرافیایی مراکز داده در مناطق تازه بیفتند. این رویکرد علاوه بر کاهش فشار بر شهرهای بزرگ، انعطافپذیری و تابآوری شبکه جهانی را هم افزایش میدهد.

رشد سریع در آسیا، آفریقا و آمریکای لاتین

-

آسیا: کشورهایی مثل هند، اندونزی و ویتنام در حال تبدیل شدن به قطبهای جدید هستند. رشد جمعیت جوان، افزایش استفاده از اینترنت و توسعه استارتاپهای دیجیتال، نیاز به زیرساخت پردازشی قدرتمند را در این مناطق بیشتر کرده است.

-

آفریقا: با گسترش دسترسی به اینترنت و سرمایهگذاری خارجی، کشورهای آفریقایی بهویژه نیجریه، آفریقای جنوبی و کنیا شاهد احداث مراکز داده جدید هستند. این موضوع به اقتصاد دیجیتال بومی قدرت میدهد و فاصله دیجیتال با سایر نقاط جهان را کمتر میکند.

-

آمریکای لاتین: بازارهایی مثل برزیل، شیلی و مکزیک به دلیل رشد تجارت الکترونیک و گسترش شبکههای مخابراتی 4G و 5G، به نقاط جذابی برای سرمایهگذاری در زمینه Data Center تبدیل شدهاند.

مزایای این توسعه جغرافیایی

-

کاهش وابستگی به چند نقطه محدود: زیرساخت جهانی مقاومتر و پایدارتر میشود.

-

بهبود تجربه کاربران محلی: پردازش و ذخیرهسازی نزدیکتر به کاربر، تأخیر را کاهش میدهد.

-

ایجاد فرصتهای اقتصادی جدید: این مراکز نهتنها فناوری را در دسترستر میکنند، بلکه شغلهای مستقیم و غیرمستقیم زیادی ایجاد خواهند کرد.

آینده این روند

بهنظر میرسد در سالهای پیش رو، جهانیسازی واقعی زیرساخت ابری رخ دهد. به این معنا که دیگر تنها چند کشور محدود میزبان بازیگران اصلی نباشند، بلکه اکوسیستم دیجیتال به شکلی عادلانهتر در سراسر دنیا توزیع شود.

روند هشتم: گاز طبیعی و نقش آن بهعنوان پل انرژی

صنعت فناوری در مسیر گذار به سمت انرژیهای پاک و تجدیدپذیر حرکت میکند. اما واقعیت این است که در کوتاهمدت، منابع سبز هنوز قادر نیستند تمام نیازهای عظیم مراکز پردازش داده و زیرساخت ابری را پوشش دهند. محدودیت ظرفیت تولید برق خورشیدی و بادی، نوسانات عرضه، و نیاز به ذخیرهسازی انرژی در مقیاس بالا، همه باعث شده این گذار زمانبر باشد.

چرا انرژیهای تجدیدپذیر کافی نیستند؟

اگرچه سرمایهگذاری جهانی روی نیروگاههای سبز بهسرعت در حال رشد است، اما فناوریهای ذخیرهسازی مثل باتریهای بزرگمقیاس هنوز در مرحله بلوغ قرار ندارند. همین موضوع باعث میشود در زمانهایی که خورشید نمیتابد یا باد نمیوزد، تولید برق پایدار مختل شود. از طرف دیگر، مراکز پردازشی نیاز به انرژی ۲۴ ساعته و بدون وقفه دارند و هیچ وقفهای در تأمین انرژی برای آنها قابل قبول نیست.

نقش گاز طبیعی بهعنوان «پل انرژی»

در چنین شرایطی، گاز طبیعی بهعنوان یک گزینه میانی و موقت وارد عمل میشود. نیروگاههای گازی انعطافپذیرند، میتوانند در زمان اوج مصرف سریعتر وارد مدار شوند و نسبت به زغالسنگ آلودگی کمتری تولید میکنند. بسیاری از شرکتهای بزرگ فناوری ترجیح میدهند تا رسیدن به نقطهای که انرژیهای سبز کاملاً پایدار و قابل اعتماد شوند، از گاز طبیعی برای تأمین بخشی از برق زیرساختهای خود استفاده کنند.

مزیتها و چالشها

-

مزایا:

-

دسترسی آسان و پایدارتر نسبت به منابع تجدیدپذیر در کوتاهمدت.

-

آلودگی کمتر نسبت به سوختهای فسیلی سنتی مانند زغالسنگ.

-

امکان ترکیب با پروژههای جذب و ذخیره کربن برای کاهش اثرات زیستمحیطی.

-

-

چالشها:

-

همچنان یک منبع فسیلی است و ردپای کربنی دارد.

-

ممکن است سرمایهگذاری بیش از حد در آن، گذار به انرژیهای ۱۰۰٪ سبز را به تأخیر بیندازد.

-

آینده ترکیب انرژی

پیشبینی میشود در سالهای پیش رو، ترکیب انرژی در این صنعت به شکل مدل هیبریدی باشد: سهمی از انرژی تجدیدپذیر (خورشیدی، بادی، آبی)، سهمی از گاز طبیعی بهعنوان پشتیبان، و بهمرور فناوریهای نو مانند هیدروژن سبز یا ذخیرهسازی پیشرفته. به این ترتیب، گاز طبیعی نقش پل انرژی را ایفا میکند؛ پلی که جهان فناوری را از دوران وابستگی به سوختهای فسیلی به سمت آیندهای کاملاً سبز هدایت خواهد کرد.

جمعبندی

تحولاتی که در سال ۲۰۲۵ پیش روی صنعت پردازش داده و مراکز ابری قرار دارد، تنها تغییرات فنی ساده نیستند، بلکه بازتابی از دگرگونی عمیق اقتصاد دیجیتال و شیوه زندگی ما هستند. از افزایش تقاضای انرژی و نیاز به خنکسازی پیشرفته گرفته تا رشد Data Centerهای ابرمقیاس و گسترش زیرساختهای لبه، همه این روندها نشان میدهند که آینده دیجیتال بیش از هر زمان دیگری به کیفیت و انعطافپذیری این زیرساختها وابسته است.

همچنین ظهور فناوریهای جدید مثل هوش مصنوعی و رایانش ابری، مسیر طراحی و بهرهبرداری از این مراکز را متحول خواهد کرد. در کنار آن، حرکت به سمت بازارهای نوظهور در آسیا، آفریقا و آمریکای لاتین، توزیع جغرافیایی متعادلتری ایجاد میکند و دسترسی به خدمات دیجیتال را جهانیتر میسازد.

در نهایت، مسئله انرژی و پایداری زیستمحیطی همچنان مهمترین چالش این صنعت خواهد بود. استفاده از گاز طبیعی بهعنوان پل انرژی تنها یک راهحل موقت است و آینده واقعی در گرو توسعه کامل انرژیهای تجدیدپذیر و فناوریهای سبز است.

آنچه روشن است این است که بازیگران اصلی این حوزه—از شرکتهای فناوری گرفته تا دولتها و سرمایهگذاران—باید از همین امروز خودشان را برای این تحولات آماده کنند. سال ۲۰۲۵ نه پایان راه، بلکه آغاز فصل تازهای برای صنعت پردازش داده است.